| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- 파이어족 자산증식

- 퀀트 트레이딩

- 추세추종 2%룰

- 데이비드 라이언

- AWS

- 마크 미너비니

- 퀀터스 하지 마세요

- 마크미너비니

- 파이어족 저축

- 제시 리버모어

- 통계적 유의성

- python

- 신의 시간술

- 파이어족 포트폴리오

- 파이어족

- GIT

- 아웃풋 트레이닝

- 니콜라스 다바스

- 자산배분

- tensorflow

- 2%룰

- 파이어족 자산

- 데이빗 라이언

- 김프

- 이클립스

- H는 통계를 모른다.

- 에드워드 소프

- eclipse

- mark minervini

- 연금저축계좌

- Today

- Total

머신러닝과 기술적 분석

Precision / Recall 본문

분류기 (Classifier) 의 성능을 평가하는 Metric 에는 Precision/Recall 이 있다.

볼 때 마다 헷갈리는 2가지 성능평가지표를 정리해두자.

Contents

- Confusion Matrix

- Precision / Recall 의 계산 방법과 수식의 해석

1. Confusion Matrix

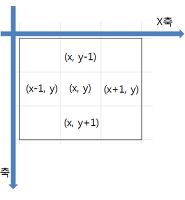

Confusion Matix 란 Binary Classfier 의 Prediction 결과를 2x2 Matrix 로 나타낸 것이다.

Confusion Matix 의 element 를 정하는 규칙은 다음과 같다.

1) 첫번쨰 Term : Prediction 과 Ground Truth 의 일치여부로 True/False 를 정한다.

2) 두번째 Term : Prediction 결과에 따라 Positive/Negative 를 정한다.

위 규칙에 따르면 총 4가지 경우의 수(첫번째 Term 2개 * 두번쨰 Term 2개)가 나오고 이것으로 아래와 같은 2x2 사이즈의 Confusion Matrix 를 구성할 수 있다.

그림 출처: 코세라 ML-Classification 수업자료

2. Precision / Recall 의 계산 방법과 수식의 해석

2.1 Precision == TP / (TP+FP) == TP / (분류기가 P 로 예측한 것)

수식의 의미를 해석해보자. 분모는 (TP+FP) 인데 두번째 Term 이 둘 다 P 이다. 즉, 분모 Term 의 의미는 분류기가 P 라고 예측한 모든 Sample 을 말한다.

결국 Precision 은 분류기가 P로 예측한 sample 중에서 맞게 예측한 것의 비율 을 의미한다.

영어 위키에는 “Precision is the probability that a retrieved one is relevant.” 라고 정의되어있다.

- retrived : 인출된, 검색된, 검출된

- relevant : 적절한

- 검출된 정보(TP+FP) 중에서 적절한 것들(TP) 의 비율을 Precision 이라고 한다.

2.2 Recall = TP / (TP+FN) = TP / (Ground Truth P 의 숫자)

Precision 과 마찬가지로 Recall 수식의 의미도 해석해보자. 분모가 (TP+FN) 이다.

- TP 는 분류기가 Positive 로 예측했는데 맞은 sample 이다.

- FN 은 분류기가 Negative 로 예측했는데 틀린 sample 이다. => 즉 Ground Truth 가 Positive 다.

위 2개를 더하면 Ground Truth 의 총 sample 숫자가 된다.

결국 Recall 은 Ground Truth 의 총 positive sample 중에서 positive로 맞게 예측한 것의 비율 을 의미한다.

영어 위키에는 “Recall is the probability of the complete retrival.” 라고 정의되어있다.

- retrived : 인출된, 검색된, 검출된

- 전체 정보(TP+FN)중에서 검출된 것(TP)의 비율을 Recall 이라고 한다.

'Machine Learning' 카테고리의 다른 글

| python 에서 RANSAC 으로 polynomial fitting 방법 (0) | 2017.09.16 |

|---|---|

| Likelihood, ML, MAP 개념 정리 (0) | 2017.08.16 |

| image morphological operations (0) | 2017.08.16 |

| Image Gradient (0) | 2017.08.16 |

| mAP (mean average precision) 의 개념 (6) | 2017.08.16 |